Datengetriebene und modellgestützte Fusion

multimodaler Sensoren

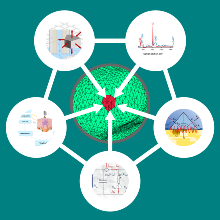

Daten aus realen Anwendungen umfassen mehrere Modalitäten, die Inhalte mit derselben Semantik aus komplementären Aspekten darstellen. Auch die intraoperative Gewebedifferenzierung basiert auf der Fusion erheblicher Datenmengen mit unterschiedlichen Informationen zur letztendlichen Abschätzung des malignen Potenzials der jeweiligen Zielstruktur. Die Herausforderung besteht darin, die Verarbeitung multimodaler Datenflüsse, d. h. die in Echtzeit aufgenommenen Daten der Sensoriken aus den Projekte A1-A5, zur interventionellen Diagnostik zu ermöglichen.

Es soll ein neuartiges Feature-Fusion-Verfahren basierend auf einer mehrstufigen Merkmalsextraktion-Struktur entwickelt werden, um die verschiedenen semantischen Feature-Gruppen zu verschmelzen und die neugenerierten Feature-Vektoren zur Klassifikation einzusetzen.

Wissenschaftliche Fragestellung

Die multimodalen Messdaten wie beispielsweise Impedanz- und Steifigkeitsdaten müssen räumlich und zeitlich sowie mit den Videodaten fusioniert werden, um gewinnbringend in die Gewebedifferenzierung einzufließen. Konkrete Fragenstellungen hierbei sind:

- Wie können Daten aus verschiedenen physikalischen Messprinzipien der elektrischen, mechanischen und optischen Domänen (A1-A5) fusioniert werden?

- Wie können Messungen, die an unterschiedlichen Positionen aufgenommen wurden, in die Sensorfusion einfließen?

- Wie kann diese erhöhte Komplexität genutzt werden, um die Gewebedifferenzierung im Hinblick auf Tumortyp, -grading und neoadjuvante Therapie auszuweiten?

Zur Bearbeitung der genannten Fragestellungen kann auf diverse Vorarbeiten der ersten Kohorte zurückgegriffen werden. Beispielsweise werden die Algorithmen zur Landmarkenextraktion (B1) und die entwickelten Generative Adversarial Networks zur Tiefenschätzung (B3) verwendet, um die Sensoren zu lokalisieren. Die bereits entworfene Datenbank liefert die Grundlage für ein effizientes Datenmanagementsystem, das in der 2. Förderperiode entwickelt werden soll.

Methodik und Lösungsansätze

Datengetriebene Gewebecharakterisierung

Zunächst wird die Sensorfusion in reduzierter Komplexität betrachtet, indem nur Sensormessungen derselben Position berücksichtigt werden. Aus den hochdimensionalen Rohdaten der Sensormessungen werden Merkmalsvektoren extrahiert, um die Dimensionalität der Daten zu reduzieren und sie in einen gemeinsamen Merkmalsraum zu überführen. Dafür eigenen sich multimodale Autoencoder oder Transformer Netzwerke. Die extrahierten latenten Merkmalsrepräsentationen können anschließend für eine Klassifikation des Gewebes genutzt werden.

Derartige Ansätze benötigen jedoch große Mengen an Sensordaten, die allein mit den verfügbaren menschlichen Gewebeproben nicht erreicht werden können. Ein Ansatz besteht darin, die Differenzierung tierischer Gewebeproben ex vivo zur Initialisierung eines multimodalen NNs zur Sensorfusion zu verwenden. Durch eine nachgelagerte Augmentation der Daten können die verfügbaren Datenmengen weiter gesteigert werden. Das so vortrainierte NN kann in weiteren Schritten mit den realen, menschlichen Testdaten und Transfer Learning Ansätzen auf die angedachte Tumordifferenzierung angepasst werden. Statt wie bei konventionellen KI-Prozessworkflows auf homogene, unimodale und gelabelte Datensätze zu setzen, können durch Transfer Learning Konzepte auch realistische, multimodale und lückenhafte Datensätze verarbeitet werden.

Detektion von Tumorgrenzen

Im intraoperativen Setup ist es nicht immer möglich und sinnvoll, Messungen mit verschiedenen Sensoren an exakt derselben Position durchzuführen. Neben der Charakterisierung des Gewebes ist zudem auch die Ausbreitung des Tumors und insbesondere die Abgrenzung zum gesunden Gewebe essenziell. Deshalb soll auf Basis räumlich verteilter Sensormessungen die Abschätzung der Tumorgrenzen prognostiziert und mit der Klassifikation gekoppelt werden. Dazu werden die in Teilprojekt B1 entwickelten Methoden zur intraoperativen Navigation verwendet.

Das Kamerabild und die optischen Sensoren (A1, A2) können z.B. zur Detektion flächiger Auffälligkeiten genutzt werden und anschließend erste Informationen für eine vorläufige Klassifikation liefern. Durch den kombinierten Einsatz weiterer Sensoren für punktuelle Einzelmessungen in Grenzgebieten, z.B. mit dem WaFe-Sensor (A4) oder dem Impedanzsensor (A5), wird das Tumorareal weiter eingegrenzt.

Bearbeiter

Matthias Ege

M.Sc.Doktorand B3

Carina Veil

Dr.-Ing.Betreuung A5, B1, B3

Cristina Tarín Sauer

Prof. Dr.-Ing.Teilprojektleiterin B3, Chancengleichheitsbeauftragte